Bisakah AI Dilatih dengan Data Sintetis yang Dibuat oleh AI Lain?

Internet akan semakin dibanjiri konten bikinan AI, lalu apa yang terjadi ketika konten-konten tersebut dipakai untuk melatih AI lain?

Penggunaan generative AI terus bertambah populer setiap harinya. Dewasa ini, menemukan konten yang dibuat oleh AI bukanlah sesuatu yang sulit. Mulai dari cerita fiksi yang dibuat menggunakan ChatGPT, gambar photorealistic yang dibuat menggunakan Midjourney, sampai klip video yang dibuat dengan Runway Gen-2, semuanya dapat kita temukan dengan mudah di internet.

Di saat yang sama, perusahaan pengembang sistem AI terus berupaya untuk menyempurnakan kreasinya. Salah satu caranya adalah dengan melatih AI menggunakan lebih banyak dataset. Belum lama ini, Meta merilis model bahasa AI Llama-2 yang diklaim telah dilatih menggunakan 40% lebih banyak data daripada sebelumnya.

'Kehausan' akan data untuk melatih AI ini pada akhirnya memicu tren penggunaan data sintetis, alias data yang dibuat menggunakan program komputer, termasuk halnya AI itu sendiri. Ya, sederhananya melatih AI dengan data yang dibuat oleh AI lain, dan berdasarkan laporan Financial Times, praktik ini rupanya sudah dilakukan oleh perusahaan-perusahaan AI terkemuka macam Microsoft dan OpenAI.

Kenapa harus data sintetis?

Dalam sebuah event yang digelar di London Mei lalu, CEO OpenAI, Sam Altman, sempat mengatakan dengan percaya diri bahwa "tidak lama lagi semua data akan menjadi data sintetis." Pendapat tersebut ia sampaikan guna menjawab kekhawatiran publik soal pelanggaran privasi yang dilakukan oleh perusahaan AI ketika melatih sistem bikinannya.

Alasan lain mengapa perusahaan AI memilih untuk menggunakan data sintetis adalah kondisi ekosistem internet yang kelewat kacau dewasa ini. "Jika Anda bisa mendapatkan semua data yang dibutuhkan dari internet, itu akan sangat luar biasa," ucap Aidan Gomez, CEO dari perusahaan AI Cohere yang juga memanfaatkan data sintetis guna melatih AI.

"Kenyataannya, internet sangatlah berisik dan berantakan sehingga tidak benar-benar mewakili data yang Anda inginkan. Internet tidak bisa memenuhi semua yang kita butuhkan," imbuhnya.

Tidak kalah penting adalah fakta bahwa data yang dibuat oleh para ahli di bidangnya itu sangat mahal harganya. Menggunakan AI untuk menghasilkan data sintetis jelas lebih terjangkau dan hemat waktu.

Studi yang dilakukan tim dari Microsoft Research belum lama ini menunjukkan bagaimana data sintetis dapat digunakan untuk melatih model AI yang sederhana. Tim penelitinya menggunakan GPT-4 untuk menciptakan dataset berisikan kumpulan cerpen untuk anak-anak berusia empat tahun. Dataset tersebut kemudian dipakai untuk melatih model bahasa AI yang sederhana, yang terbukti mampu menciptakan cerita secara fasih dan terstruktur.

Tim lain dari Microsoft Research juga sempat merilis makalah yang menunjukkan bagaimana AI bisa dilatih menggunakan kode-kode Python sintetis yang dikemas dalam bentuk buku dan soal-soal latihan. Hasilnya, kinerja AI tersebut terbukti cukup layak dalam beberapa tugas pemrograman.

Dampak buruk melatih AI dengan data sintetis

Meski terdengar menjanjikan, penggunaan data sintetis untuk melatih AI harus dilakukan secara hati-hati. Dalam dua contoh tadi, data sintetis yang dipakai pada dasarnya adalah hasil kurasi manusia. Tanpa kurasi manusia, efeknya justru bisa negatif.

Riset yang dilakukan tim peneliti dari Oxford dan Cambridge University baru-baru ini memperingatkan bahaya melatih model AI dengan output mentahnya, yang mungkin mengandung informasi yang keliru atau hasil karangannya sendiri. Hal ini diyakini bisa menyebabkan "cacat permanen" pada AI-nya, yakni kondisi ketika materi asli yang dijadikan bahan berlatih justru hilang tidak berbekas.

"Kami menunjukkan bahwa hal ini harus ditanggapi dengan serius jika kita ingin mempertahankan manfaat pelatihan menggunakan data berskala besar yang dikumpulkan dari internet. Data yang dikumpulkan tentang interaksi manusia dengan sistem akan jadi semakin berharga di tengah banyaknya konten yang dihasilkan oleh LLM dalam data yang didapat dari internet," tulis tim penelitinya.

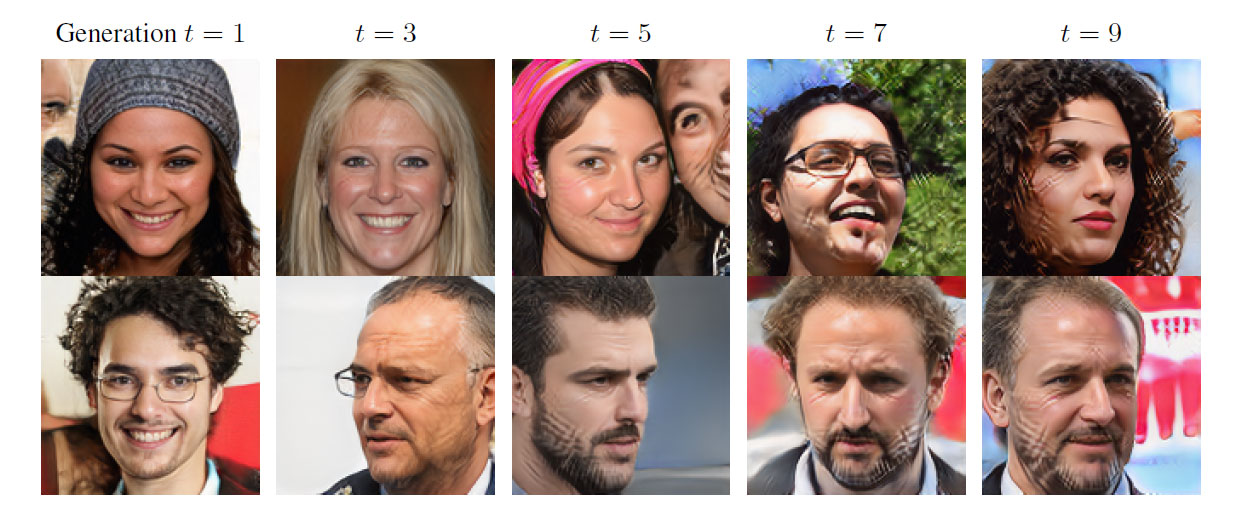

Pendapat serupa juga disampaikan oleh tim peneliti dari Rice dan Stanford University. Mereka baru-baru ini memublikasikan studi mengenai "self-consuming generative models", yang juga menunjukkan bahaya melatih AI menggunakan data sintetis yang dibuat oleh AI.

"Kemajuan pesat dalam algoritma generative AI untuk menciptakan gambar, teks, dan jenis data lainnya telah memicu godaan untuk menggunakan data sintentis untuk melatih model generasi berikutnya. Mengulangi proses ini akan menciptakan autophagous loop (memakan diri sendiri) yang sifat-sifatnya belum dipahami dengan baik," tulis timnya.

"Kesimpulan utama kami di seluruh skenario adalah bahwa tanpa data nyata yang cukup di setiap generasi dari sebuah autophagous loop, model generatif masa depan akan mengalami penurunan kualitas (presisi) dan keanekaragaman (ingatan) secara progresif. Kami menyebut kondisi ini sebagai Model Autophagy Disorder (MAD), yang dianalogikan seperti penyakit sapi gila."

Dengan kata lain, tanpa "data nyata" — yang dibuat oleh manusia dan bukan hasil sintesis AI — untuk melatih suatu model AI, kualitas output yang dihasilkan bakal menurun drastis.

Seperti dilaporkan Tom's Hardware, timnya turut menjelaskan bahwa ketika AI dilatih berulang kali menggunakan data sintetis, elemen-elemen informasi yang lebih jarang muncul dalam suatu dataset akan mulai menghilang. AI tersebut kemudian akan mulai menarik data yang semakin menyatu dan kurang bervariasi, dan akibatnya, AI akan bingung sendiri.

Berdasarkan hasil percobaan tim peneliti, butuh sekitar lima putaran pelatihan dengan data sintetis sebelum akhirnya fenomena MAD terjadi, dan mulai muncul banyak kejanggalan pada output yang dihasilkan.

Berbicara kepada Futurism, tim penelitinya menjelaskan bahwa batasannya berbeda-beda tergantung model dan situasinya. Data sintetis dalam porsi kecil di tengah-tengah data asli dalam jumlah masif juga tidak akan memicu fenomena MAD, sehingga menjaga keseimbangan porsinya dalam suatu dataset merupakan suatu langkah kunci yang harus selalu diperhatikan.

Yang berpotensi menjadi masalah adalah ketika dataset-nya diambil langsung dari internet. "Karena kumpulan data pelatihan untuk generative AI kerap diambil dari internet, model-model AI saat ini tanpa disadari dilatih dengan semakin banyak data yang dibuat oleh AI," tulis tim peneliti dalam studinya.

Mereka mencontohkan dataset LAION-5B yang sangat populer, yang digunakan untuk melatih AI image generator seperti Stable Diffusion. Dataset tersebut rupanya mencakup gambar-gambar yang dibuat menggunakan AI image generator generasi sebelumnya.

"Sumber teks yang dulunya berasal dari manusia kini semakin banyak dibuat oleh generative AI, mulai dari ulasan pengguna hingga situs berita, sering kali tanpa ada indikasi bahwa teks tersebut merupakan hasil sintesis. Seiring berkembang pesatnya penggunaan generative AI, situasinya hanya semakin bertambah cepat," imbuh mereka.

Apa implikasinya bagi pengguna?

Bagi para pengguna, implikasi tren pelatihan AI menggunakan data sintetis sebenarnya cukup simpel: kalau siklus ini diteruskan, maka output yang dihasilkan generative AI akan jadi bertambah monoton dan biasa saja. Lalu apa yang bisa pengguna lakukan untuk membantu mengatasi isu ini?

Salah satunya adalah dengan tidak menonaktifkan fitur watermarking (kalau ada) ketika menggunakan tools generative AI. Dengan adanya watermark, menyortir data sintetis dan data asli dalam suatu dataset akan menjadi lebih mudah, sebab ada penanda yang jelas untuk setiap konten yang dibuat menggunakan AI.

Pada akhirnya, tren ini akan membantu menggarisbawahi pentingnya peran manusia dalam perkembangan generative AI. Tanpa materi berkualitas yang diciptakan manusia, generative AI tidak akan mampu mencapai titik ini. Dan ketika mereka sudah mulai mengandalkan data sintetis seperti sekarang pun, manusia tetap punya peran krusial sebagai kurator.

Gambar header: Markus Spiske via Unsplash.

vivo V29e, Smartphone Handal untuk Group Photo

3 January 2024

Performa Gahar ASUS Zenfone 10 dengan Snapdragon 8 Gen 2

16 December 2023

Kamera 50MP OIS di ASUS Zenfone 10 yang Dapat Diandalkan

15 December 2023

Emang Boleh HP Flagship Layarnya Kecil? Review ASUS Zenfone 10

12 December 2023

Rahasia Advanced Multitasking di Samsung Galaxy Z Fold5

5 September 2023